цифровое присутствие - это элемент с большим потенциалом для всех видов компаний, личностей или пользователей, которые хотят иметь большее охват их услуг и контента. Теперь создать веб-сайт может быть довольно просто, но вы также должны учитывать, как он будет ранжироваться в поисковых системах.

Знание веб-сканеров позволит нам понять, что стоит за анализом производительности наших веб-сайтов или веб-сайтов конкурентов, мониторинг упоминаний или конкретных терминов и позиционирования страниц в поисковых системах.

Что такое поисковый робот?

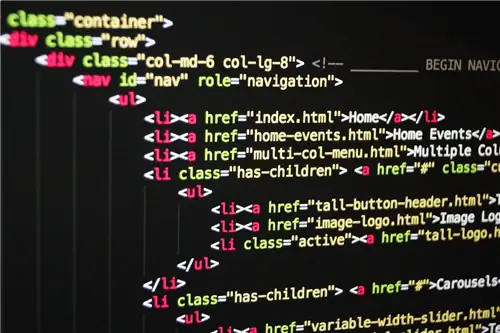

Сканер или бот - это алгоритм, запрограммированный на просмотр HTML-кода веб-страницы, сбор информации и ее сохранение в соответствии с с целью.

Они известны как «веб-пауки», поскольку, если мы визуализируем Интернет как сеть, сайты будут соответствовать узлам и гиперссылкам, которые соединяют их с потоками, по которым поисковые роботы выполняют свои функции. с одной стороны на другую, похоже на поведение пауков

Эти «пауки» читают код в поисках HTML-тегов и анализируют текст вместе с найденными внутри него метаданными. После анализа программой собранные данные можно использовать для создания отчетов, проверки скорости загрузки сайта, индексации веб-страниц в поисковых системах или других параметров, которые мы определили ранее..

Некоторые типы поисковых роботов

Алгоритм этого веб-паука адаптируется к нашим требованиям и позволит нам проверять веб-сайты быстрее, чем если бы мы делали это вручную. Эти возможности позволяют нам использовать алгоритмы для автоматизации различных типов веб-аналитики, таких как:

Тематический мониторинг

Веб-сканированию можно придать другую функцию, запрограммировав его на поиск определенной информации в HTML-коде. Упражнение очень похоже на так называемое «отсечение прессы». Применительно к цифровой среде мы можем собирать информацию о концепции с течением времени в целевой аудитории на основе их упоминаний в Интернете и даже планировать оповещения, когда публикуется новый контент, связанный с нашей темой.

SEO и поисковые роботы

Одним из наиболее распространенных применений этих алгоритмов является работа поисковых систем, таких как Google, Bing или Yahoo!, для автоматизации поискановых сайтов и облегчить их интеграцию в ваши индексы. Чтобы добиться этого и позиционировать одни результаты выше других, каждый разработчик определяет технические правила в своей поисковой системе.

Эта деятельность известна как поисковая оптимизация или SEO и представляет собой метод улучшения видимости веб-сайтов, распознаваемый и применяемый в содержании. творчество.

Важность анализа HTML-кода

Итак, как мы можем облегчить поиск нашего сайта? Как мы уже упоминали, поисковые роботы работают, просматривая HTML-код, поэтому очень важно писать качественный код и контент, где текст в семантических тегах HTML имеет отношение к вашему разделу на сайте.

Среди этих тегов мы находим header, main, article и footer, которые сегментируют веб-сайт и предоставляют информацию о типе информации, содержащейся на нем.

Как сайт интегрируется в поисковую систему?

Чтобы поисковые системы отображали ссылку на веб-сайт в качестве результата поиска, необходимо выполнить первый шаг: индексировать веб-сайт Чтобы поисковые роботы Google выполняли сканирование веб-страниц, необходимо наличие обратных ссылок, то есть ссылок с внешних страниц на наши.

После выполнения этой задачи пауки смогут отслеживать путь, анализировать код и собирать информацию, необходимую для индексации сайта на серверах Google, который будет включать информацию, видимую в результатах, такую как заголовок, метаописание и ссылку на веб-сайт.

Первая фаза взаимодействия сайта с поисковой системой происходит при индексации сети, поэтому Google рекомендует не использовать купленные ссылки, продвигая соединение органически content из-за его качества в отношении темы, к которой он относится. Таким образом, поисковый робот является универсальным инструментом для автоматизации анализа веб-страниц в поисках информации. Его знание может открыть возможности его использования исходя из различных целей, помимо улучшения позиций сайта в поисковой системе.