Я раздумывал, стоит ли оценивать фальшивые новости Facebook и роль, которую платформа сыграла в президентских выборах в США в 2016 году. Во-первых, кажется, что большинство людей в значительной степени устали от Трампа против Клинтона и нуждаются в небольшом перерыве, чтобы осмыслить все это и оценить, где мы находимся, и участие Facebook также было так широко освещено на других платформах, что я был не уверен, что это нужно повторять здесь.

Но читатели спрашивали об этом и почему мы не освещали это, поэтому вот три момента, которые, я думаю, имеют отношение к дебатам и долгосрочным последствиям результатов президентских выборов в США 2016 года.

1. Facebook абсолютно повлиял на голосование

Отрицать это нелогично - Facebook теперь играет неотъемлемую роль в распространении и распространении новостей, и, таким образом, он также играет роль в том, как люди информируются, тем самым влияя на то, что они думают. Добавьте к этому тот факт, что новостная лента Facebook работает на основе алгоритма, который предоставляет пользователям больше контента, похожего на тот, с которым они взаимодействуют, и связь будет довольно очевидной.

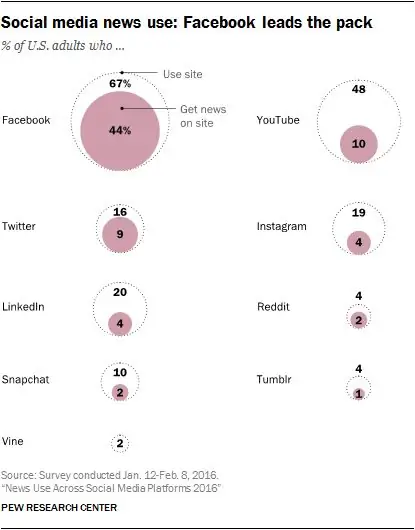

На самом деле, это даже не обсуждается - как уже упоминалось в другом месте, исследования показывают, что 67% американцев используют Facebook, и две трети из них получают там новости, что соответствует примерно 44% всего населения, которое получить хоть какие-то их новости с сайта.

Сейчас это число, вероятно, даже выше - это исследование было проведено Pew Research еще в январе, и с тех пор база пользователей Facebook в Северной Америке выросла на семь миллионов. Справедливо предположить, что значительное количество этих новых пользователей теперь также получают обновления новостей с сайта.

В отличие от снижения общего потребления телепередач и числа читателей газет, влияние очевидно - так или иначе, растущая известность Facebook как источника средств массовой информации означает, что платформа абсолютно обладает значительным влиянием на доставку новостей, что, в свою очередь,, влияет на поведение аудитории, но на самом деле этот случай был доказан даже более определенно, чем это.

В 2010 году около 340 000 дополнительных избирателей приняли участие в выборах в Конгресс США из-за единственного сообщения в Facebook в день выборов. Это основано на исследовании, проведенном в соавторстве с Facebook, в котором они заявили, что это было:

Процесс, который они использовали, чтобы доказать это, был относительно простым:

Результаты показали, что пользователи, получившие «информационное» сообщение (верхнее сообщение на скриншоте выше), проголосовали с той же скоростью, что и те, кто вообще не видел сообщения, в то время как те, кто видел «социальное» сообщение - с включенными изображениями своих друзей (нижний пример на снимке экрана выше) на 2% чаще нажимали кнопку «Я проголосовал» и на 0,4% чаще направлялись на выборы, чем другая группа. Основываясь на этом, исследователи подсчитали, что социальное сообщение напрямую увеличило явку избирателей на 60 000 голосов, в то время как еще 280 000 человек были «косвенно подтолкнуты к участию в опросах», увидев сообщения в своих новостных лентах - «уведомления о том, что их друзья проголосовали»..

Это прямое влияние на выборы через контент Facebook. Это даже не гипотеза, это исследование - опять же, в соавторстве с Facebook - доказывает это.

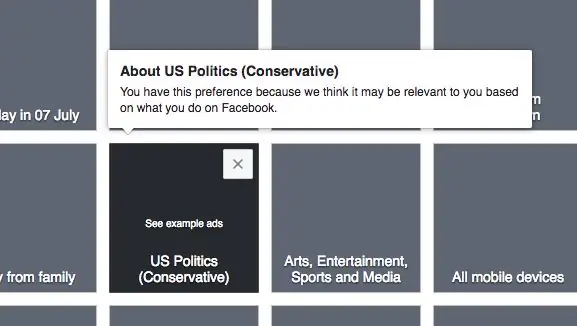

Хотите узнать, считает ли вас Facebook более либеральным или консервативным, основываясь на ваших действиях на платформе? Вы тоже можете сделать это - зайдите на www.facebook.com/ads/preferences, нажмите на вкладку «Образ жизни и культура» в разделе «Интересы», затем найдите в этом разделе поле под названием «Политика США».

Опять же (и как отмечено на изображении), это основано на ваших действиях на платформе, Facebook хорошо осведомлен о политических пристрастиях пользователей и использует их в качестве варианта таргетинга, поэтому этот фактор определенно имеет значение. некоторое влияние на контент, который вы видите. Все эти элементы указывают на тот факт, что Facebook абсолютно влияет на политические взгляды и то, как люди впоследствии голосуют - и даже на базовом уровне, на вашем собственном использовании платформы, вы это знаете.

Например, предположим, что вы просматриваете свою ленту новостей, и вы сторонник Дональда Трампа, и есть ваш друг, который публикует кучу ссылок на статьи о том, какой плохой Трамп и какая Хиллари великая. Он становится раздражающим. Вы отписываетесь от него. Конечно, это находится под контролем пользователя, а не платформы, но в лучшем случае Facebook способствует расширению политических эхо-камер, упрощая отфильтровывание всего, что не соответствует вашей точке зрения. Алгоритм фида также использует эти действия в качестве сигналов, чтобы предоставить вам более релевантный для вас контент, и мы знаем, что Facebook может делать выводы о политических взглядах на основе таких действий.

Новостная лента показывает вам больше того, чем вы занимаетесь, с чем, скорее всего, вы согласны, и меньше того, с чем вы не согласны. По замыслу, его теория подкрепления на практике - но тогда вопрос в том, было ли этого влияния достаточно, чтобы изменить голосование.

2. Устранение фейковых новостей, вероятно, не даст решения

Генеральный директор Facebook Марк Цукерберг отверг мнение о том, что поддельный или вводящий в заблуждение контент мог повлиять на результат выборов, отметив, что он составляет лишь около 1% контента в сети. Это кажется недооценкой, учитывая факты.

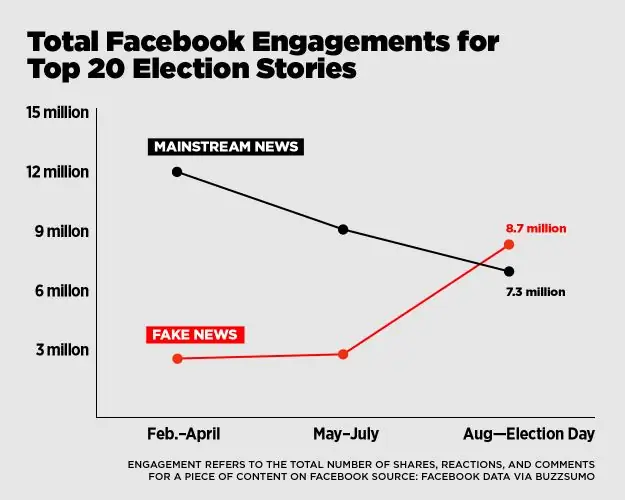

Например, BuzzFeed недавно опубликовал результаты своего расследования, которое показало, что за последние три месяца президентской кампании в США «самые популярные фальшивые новости о выборах на Facebook привлекли больше внимания, чем главные новости из крупных новостные агентства, такие как New York Times, Washington Post, Huffington Post, NBC News и другие"

Теперь это не весь контент на Facebook, это лишь его подмножество, выбранное BuzzFeed, но все же есть четкая тенденция того периода с мая по июль. Так что же произошло за этот промежуток времени, что могло оказать влияние.

Это, по-видимому, коррелирует с предыдущими исследованиями: как было отмечено в ходе предвыборного эксперимента 2010 г., люди побуждались действовать, когда им показывали «социальное» сообщение, изображение с фотографиями ваших друзей, что усиливало давление сверстников на уведомление. Скачок в распространении фейковых новостей основан на том же принципе - изменение алгоритма Facebook сделало больший акцент на том, чем делились ваши друзья перед публикациями на Странице, увеличивая охват, а также подразумеваемое давление со стороны сверстников этих точек зрения. Если бы ваши друзья больше интересовались этим контентом и делились им, вы должны были бы увидеть его больше - объедините это с более активным обсуждением выборов, и теория обретет смысл. Распространение фальшивых новостей увеличивается, эти сообщения влияют на большее количество людей, и результат уже достигнут.

Но даже если эти фальшивые отчеты достигли более широкой аудитории, действительно ли они могли повлиять на то, как люди проголосовали?

Этот элемент доказать гораздо сложнее. Теперь ясно, что фальшивые новости распространялись на протяжении всего периода выборов - даже инсайдеры Facebook (как сообщается) признали это. Такие истории, как Папа, поддержавший Дональда Трампа, Билл Клинтон, обвиненный в изнасиловании ребенка, убийство кого-то, кто должен был дать показания против Хиллари Клинтон, - все эти лживые заявления набрали обороты в Интернете и, вероятно, так или иначе укрепили поддержку людей, но эти истории только набрал обороты из-за большей озабоченности новостной лентой Facebook, которая активно работает над предоставлением большего количества контента, который поддерживает ваши существующие убеждения, изгоняя при этом альтернативные точки зрения. С этой точки зрения кажется более вероятным, что фальшивые отчеты просто укрепляли ранее существовавшие мнения людей, а не формировали их, но это не учитывает огромное количество неопределившихся избирателей, которые, учитывая окончательный перевес, повлияли бы на результат.

Исходя из приведенного выше исследования, можно предположить, что то, чем делятся ваши друзья, определенно способно вдохновить на действия в реальном мире, и, учитывая большее количество фальшивых историй, влияние кажется очевидным.

Но даже если это так, то основная проблема заключается не в фейковых новостях, а в эхо-камере - людям показывают больше того, с чем они согласны, и впоследствии они взаимодействуют с этим контентом, что приводит к тому, что контент, имеющий больший охват и влияние. А поскольку алгоритм учится на ваших действиях на платформе, они также все меньше и меньше знакомятся с точкой зрения другой стороны, поэтому их точка зрения с каждым постом только подчеркивается все больше и больше.

Например, если вы увидели сообщение в своей ленте, в котором говорилось, что Хиллари Клинтон сознательно финансирует терроризм, и вы нажали на него, Facebook воспримет это как показатель того, что вы интересуетесь этой темой, и вы можете внезапно увидеть больше историй в том же духе, в то время как противоположные взгляды будут уменьшены в зависимости от ваших политических предпочтений.

Эта поляризация была подчеркнута в исследовании, проведенном The Guardian, в котором они попросили десять избирателей - пять консерваторов и пять либералов - перейти на другую сторону и посмотреть на ленты Facebook с другой точки зрения в последний месяц кампании. The Guardian создала два аккаунта в Facebook, один следил за пролиберальными новостными сайтами, а другой проконсервативный, а затем передала их участникам противоположной точки зрения.

Участники были поражены охватом, который они увидели: один описал этот опыт как «как чтение книги дураком», а другой сказал, что это было «как быть запертым в комнате, полной людей, страдающих паранойей». заблуждения.

Эксперимент показал, что контент, который видит каждая сторона, очень разный, но это не обязательно были фальшивые новости или ложь, которые влияли на их выбор. На самом деле ни один из участников в результате не изменил свой голос, и никто из них не сделал конкретной пометки о том, что ложь опровергается другой стороной. У участников были ранее существовавшие убеждения, которые подпитывались их собственным опытом и связями - то, что они видели на Facebook, только помогло их укрепить.

Один участник отметил, что:

Это кажется более серьезной проблемой, чем фейковые новости, что люди так легко могут отключить инакомыслие. Мы предполагаем, что те, кто находится на другой стороне дебатов, видят те же доказательства, что и мы, потому что мы полностью устраняем счетчик, поэтому мы так скептически относимся к тому, что так много людей в конечном итоге поддерживают противоположную точку зрения.

В этом смысле роль, которую фейковые новости сыграли в этом процессе, является лишь частью более крупной проблемы. Определенно, увеличение распространения фальшивых историй помогло бы оправдать существующие пристрастия людей, и это, как вы можете предположить, впоследствии повлияло на неопределившихся избирателей. Но в целом, если бы вы удалили поддельный контент из уравнения, это, возможно, фактически не изменило бы результат.

Несмотря на то, что устранение фейковых новостей является положительным шагом в любом случае, эхо-камера является более спорным элементом, и это реальная проблема, которую мы должны обсуждать в отношении Facebook.

3. Что дальше?

И вот большой вопрос. Теперь, когда Трамп стал президентом США, а нация кажется более разделенной, чем когда-либо, что будет дальше? Какое влияние окажут эхо-камеры социальных сетей на усиление существующих разногласий и побуждение людей принять чью-либо сторону?

Больше, чем когда-либо, люди нуждаются в понимании - они должны понять, почему люди будут голосовать за ту или иную сторону, что привело их к такому выводу, потому что кажется, что большинство было явно шокировано результатом и что люди искренне пытаясь понять, почему избиратели противоположной точки зрения поддержали того или иного кандидата.

Прямо сейчас это точка зрения, которая нам нужна, чтобы увидеть существующие проблемы и проблемы и двигаться вперед, но проблема здесь в том, что с эффектом эхо-камеры это может быть невозможно. Если существующие взгляды людей только подкрепляются средствами массовой информации, которые они потребляют, то мы, вероятно, увидим, что со временем эти разногласия станут более значительными и более серьезными проблемами. И, учитывая текущее состояние, это огромная проблема, которую необходимо решить.

В этом отношении анализ возможной роли Facebook в президентских выборах 2016 года в США должен быть не столько связан с тем, как разыгрались результаты, сколько с тем, как люди получают информацию, и как мы можем обеспечить большее разнообразие мнений. чтобы лучше совместить эти две противоположные точки зрения. Конечно, мы никогда не сойдемся во взглядах, но если мы сейчас разделены, и в середине есть влиятельная среда, построенная, по сути, на еще большем разжигании этого разделения, кажется, что ситуация будет только хуже.

И решение может быть трудно определить - Facebook работает над тем, чтобы предоставить пользователям больше контента, который им нравится и который они хотят видеть, что в конечном итоге дает власть в их руки. Если пользователи хотят сузить свою точку зрения, они могут это сделать. Учитывая это, как вы мешаете людям заглушать противоположные голоса и лучше понимать тех, кто их окружает?

Раньше вы смотрели новости по телевизору, читали газету - все эти источники, по крайней мере, давали некоторое представление об альтернативных точках зрения или событиях. Но теперь это основано на перспективе, на интересах - вы можете оттачивать только те вещи, которые вас интересуют, и просто видеть все больше и больше этого, подчеркивая, усиливая и усиливая свое сопротивление или согласие.

Это, вероятно, будет одной из самых насущных проблем следующего этапа развития медиа, и прямо сейчас это похоже на горячую точку, критический момент, когда становится очевидным истинное влияние этой новой медиаконструкции. Как мы справляемся с ними теперь, когда мы зашли так далеко в этом новом цикле самоконтроля и контроля пользователей, на данном этапе никто не может ответить.