Ash Fontana Contributor Поделиться в Твиттере Эш Фонтана, управляющий директор Zetta Ventures, является автором книги «Компания AI-First: как конкурировать и побеждать с помощью искусственного интеллекта». Другие сообщения этого автора

Вырос в эпоху разведки

Инвесторы в технологические компании, специализирующиеся на искусственном интеллекте, обслуживающие оборонную промышленность, такие как Palantir, Primer и Anduril, преуспевают. Anduril, например, менее чем за четыре года достиг оценки более чем в 4 миллиарда долларов. Многие другие компании, создающие универсальные технологии, ориентированные на искусственный интеллект, такие как маркировка изображений, получают значительную (нераскрытую) часть своих доходов от оборонной промышленности.

Инвесторы в технологические компании, занимающиеся технологиями искусственного интеллекта, которые даже не предназначены для обслуживания оборонной промышленности, часто обнаруживают, что эти фирмы в конечном итоге (а иногда и непреднамеренно) помогают другим влиятельным учреждениям, таким как полиция, муниципальные учреждения и медиакомпании. выполнять свои обязанности.

Большинство из них делают много полезного, например, DataRobot помогает агентствам понять распространение COVID, HASH запускает симуляции распространения вакцины или Lilt делает школьные сообщения доступными для родителей-иммигрантов в школьном округе США.

Первый шаг к тому, чтобы взять на себя ответственность, - это знать, что, черт возьми, происходит. Инвесторам стартапов легко избавиться от необходимости знать, что происходит внутри моделей на основе ИИ.

Однако есть и менее позитивные примеры: технология, разработанная израильской фирмой киберразведки NSO, использовалась для взлома 37 смартфонов, принадлежащих журналистам, правозащитникам, руководителям предприятий и невесте убитого саудовского журналиста Джамаля Хашогги., согласно сообщению The Washington Post и 16 медиа-партнеров. В отчете утверждается, что телефоны были в списке из более чем 50 000 номеров в странах, которые следят за своими гражданами и, как известно, пользовались услугами израильской фирмы.

Инвесторам этих компаний теперь могут задавать сложные вопросы другие учредители, партнеры с ограниченной ответственностью и правительства о том, является ли технология слишком мощной, дает ли слишком много возможностей или применяется слишком широко. Это вопросы степени, но иногда их даже не задают при инвестировании.

Я имел честь общаться со многими людьми с разными точками зрения - генеральными директорами крупных компаний, основателями (на данный момент!) небольших компаний и политиками - с момента публикации «The AI-First Company» и инвестирования в таких фирмах в течение большей части десятилетия. Мне снова и снова задают один важный вопрос: как инвесторы гарантируют, что стартапы, в которые они инвестируют, ответственно применяют ИИ?

Давайте будем откровенны: начинающим инвесторам легко отмахнуться от такого важного вопроса, сказав что-то вроде: «Трудно сказать, когда мы инвестируем.«Стартапы - это зарождающиеся формы чего-то грядущего. Тем не менее, стартапы, ориентированные на ИИ, с первого дня работают с чем-то мощным: инструментами, которые позволяют использовать рычаги далеко за пределами нашей физической, интеллектуальной и временной досягаемости.

ИИ не только дает людям возможность брать в руки более тяжелые объекты (роботы) или улавливать больше данных (аналитика), но и дает им возможность ориентироваться во времени (прогнозы). Когда люди могут делать прогнозы и учиться во время игры, они могут учиться быстро. Когда люди могут быстро учиться, они могут действовать быстро.

Как и любой инструмент, эти инструменты можно использовать как во благо, так и во вред. Вы можете использовать камень, чтобы построить дом, или вы можете бросить его в кого-нибудь. Вы можете использовать порох для красивых фейерверков или стрельбы пулями.

По сути, похожие модели компьютерного зрения на основе искусственного интеллекта можно использовать для определения движений танцевальной группы или террористической группы. Дроны с искусственным интеллектом могут наводить на нас камеру, спускаясь с трамплина, но они также могут наводить на нас оружие.

Эта статья посвящена основам, показателям и политике ответственного инвестирования в компании, ориентированные на ИИ.

Основы

Инвесторы и члены правления компаний, ориентированных на ИИ, должны нести хотя бы частичную ответственность за решения компаний, в которые они инвестируют.

Инвесторы влияют на учредителей, хотят они этого или нет. Основатели постоянно спрашивают инвесторов о том, какие продукты создавать, к каким клиентам обращаться и какие сделки заключать. Они делают это, чтобы учиться и повышать свои шансы на победу. Они также делают это отчасти для того, чтобы привлечь и информировать инвесторов, поскольку они могут быть ценным источником капитала.

Инвесторы могут думать, что они действуют полностью по Сократовски, как рупор для учредителей, но реальность такова, что они влияют на ключевые решения, даже просто задавая вопросы, не говоря уже о том, чтобы давать конкретные советы о том, что строить, как его продать и сколько брать. Вот почему инвесторам нужна собственная система ответственного инвестирования в ИИ, чтобы они не повлияли на плохой результат.

Члены Совета директоров вносят свой вклад в ключевые стратегические решения - юридически и практически. На заседаниях совета директоров принимаются ключевые решения о продуктах, ценах и упаковке. Некоторые из этих решений влияют на то, как используется основная технология - например, следует ли предоставлять эксклюзивные лицензии правительствам, создавать иностранные дочерние компании или получать личные разрешения на безопасность. Вот почему членам совета директоров нужна собственная структура для ответственного инвестирования в ИИ.

Метрики

Первый шаг к тому, чтобы взять на себя ответственность, - это знать, что, черт возьми, происходит. Инвесторам стартапов легко избавиться от необходимости знать, что происходит внутри моделей на основе ИИ. Многим инвесторам в программное обеспечение достаточно протестировать код, чтобы убедиться, что он работает, прежде чем отправлять его клиенту.

Тем не менее, продукты с искусственным интеллектом постоянно адаптируются, развиваются и порождают новые данные. Некоторые считают мониторинг ИИ настолько сложным, что практически невозможным. Тем не менее, мы можем настроить как метрики, так и системы управления, чтобы отслеживать влияние продуктов, ориентированных на ИИ.

Мы можем использовать жесткие метрики, чтобы выяснить, работает ли система стартапа на основе ИИ вообще или она выходит из-под контроля. Правильные метрики зависят от типа метода моделирования, данных, используемых для обучения модели, и предполагаемого эффекта от использования прогноза. Например, когда целью является попадание в цель, можно измерить истинные/ложноположительные/отрицательные показатели.

Чувствительность и специфичность также могут быть полезны в приложениях для здравоохранения, чтобы получить некоторое представление об эффективности диагностического продукта: выявляет ли он достаточное количество заболеваний за достаточное время, чтобы оправдать стоимость и болезненность диагностического процесса? В книге есть объяснение этих метрик и список метрик, которые следует учитывать.

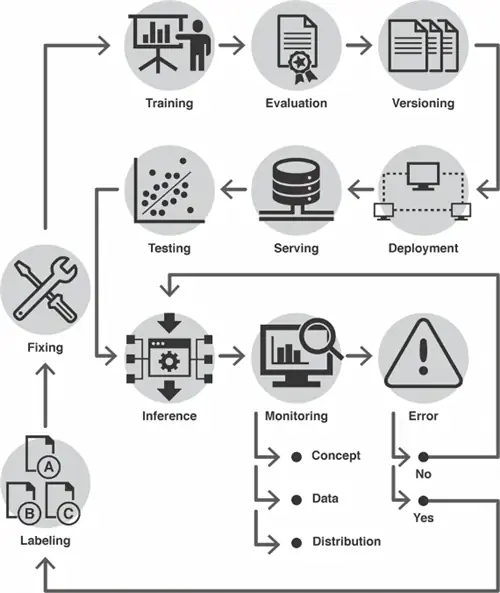

Мы также можем реализовать цикл управления машинным обучением, который улавливает модели до того, как они уйдут из реальности. «Дрейф» - это когда модель обучается на данных, которые отличаются от текущих наблюдаемых данных, и измеряется путем сравнения распределений этих двух наборов данных. Необходимо регулярно измерять дрейф модели, учитывая, что мир меняется постепенно, внезапно и часто.

Мы можем измерять постепенные изменения, только если мы получаем метрики во времени, внезапные изменения можно измерить, только если мы получаем метрики, близкие к реальному времени, а регулярные изменения измеримы, только если мы накапливаем метрики с одинаковыми интервалами. На следующей схеме показаны некоторые этапы цикла управления машинным обучением, чтобы мы могли понять, насколько важно постоянно и последовательно измерять одни и те же параметры на каждом этапе процесса создания, тестирования, развертывания и использования моделей.

Вопрос предвзятости в ИИ является проблемой как этической, так и технической. Здесь мы имеем дело с технической частью и резюмируем управление машинным уклоном, рассматривая его так же, как мы часто управляем человеческим уклоном: с жесткими ограничениями. Установка ограничений на то, что может предсказать модель, кто получает доступ к этим прогнозам, ограничения на данные обратной связи, допустимое использование прогнозов и многое другое требует усилий при проектировании системы, но обеспечивает надлежащее оповещение.

Кроме того, установление стандартов для обучающих данных может увеличить вероятность этого с учетом широкого диапазона входных данных. Поговорить с разработчиком модели - лучший способ понять риски любой предвзятости, присущие их подходу. Рассмотрите автоматические действия, такие как завершение работы или оповещение после установки этих ограничений.

Политика

Помощь влиятельным институтам путем предоставления им мощных инструментов часто интерпретируется как прямая поддержка политических партий, которые привели их к власти. Согласие часто предполагается - правильно или неправильно - и влечет за собой последствия. Члены команды, клиенты и потенциальные инвесторы, связанные с различными политическими партиями, могут не захотеть работать с вами. СМИ могут ориентироваться на вас. Этого следует ожидать и, таким образом, выражать внутренне как явный выбор в отношении того, работать ли с такими учреждениями.

Первичные, наиболее прямые политические вопросы возникают у инвесторов, когда компании работают на военных. Мы видели, как крупные компании, такие как Google, сталкивались с забастовками сотрудников только из-за возможности заключения военных контрактов.

Второстепенные политические вопросы, такие как личная неприкосновенность частной жизни, являются скорее вопросом степени с точки зрения того, стимулируют ли они давление с целью ограничения использования ИИ. Например, когда группы гражданских свобод нацелены на приложения, которые могут посягать на частную жизнь человека, инвесторам, возможно, придется рассмотреть ограничения на использование этих приложений.

Третичные политические вопросы, как правило, носят промышленный характер, например, как ИИ может повлиять на то, как мы работаем. Инвесторам трудно управлять ими, потому что влияние на общество часто невозможно определить по временной шкале, в течение которой могут действовать политики, т. е. по нескольким годам.

Ответственные инвесторы будут постоянно учитывать все три области - военную, конфиденциальную и промышленную - представляющие политическую озабоченность, и устанавливать внутреннюю политику - краткосрочную, среднесрочную и долгосрочную - в соответствии с близостью политического риска.

Возможно, первые компании с искусственным интеллектом, которые хотят установить мир в нашем мире, могут прийти к выводу, что им в конечном итоге придется «выбрать сторону», чтобы расширить свои возможности. Это сильная точка зрения, но она оправдывается некоторыми (в основном утилитарными) взглядами на насилие.

В заключение

Обязанности инвесторов в области ИИ очень глубоки, и инвесторы в этой области редко знают, насколько глубоки, когда они только начинают, часто не в полной мере оценивая потенциальное влияние своей работы. Возможно, решение состоит в том, чтобы разработать надежную этическую основу для последовательного применения ко всем инвестициям.

Я не углублялся в этические рамки, потому что, ну, они требуют томов, чтобы должным образом их обдумать, целую жизнь, чтобы построить для себя и то, что кажется целой жизнью, чтобы построить для компаний. Достаточно сказать, что я считаю, что философов можно было бы лучше использовать в компаниях, занимающихся ИИ, для разработки таких сред.

До тех пор инвесторы, знакомые с основами, показателями и политикой, надеюсь, окажут хорошее влияние на создателей этой мощнейшей технологии.

Отказ от ответственности: Автор является инвестором двух компаний, упомянутых в этой статье (HASH и Lilt) через фонд (Zetta), где он является управляющим партнером.