Intel, Qualcomm, Google и NVIDIA участвуют в разработке процессоров и платформ AI

Лаборатории искусственного интеллекта участвуют в разработке процессоров, которые больше, быстрее и сильнее.

Поскольку крупные компании, развертывающие AI-чипы и более мелкие стартапы, прижимаются к своим пяткам, не отрицают, что будущее искусственного интеллекта действительно уже на нас. Хотя каждый может похвастаться немного отличающимися функциями, все они стремятся обеспечить простоту использования, скорость и универсальность. Производители демонстрируют большую адаптивность, чем когда-либо прежде, и быстро развивают новые версии для удовлетворения растущего спроса.

На рынке, который обещает ничего не делать, но расти, эти четыре готовы к удару.

Процессор Neural Processing от Qualcomm

The Verge сообщает, что процессоры Qualcomm составляют около 40% рынка мобильной связи, поэтому их вход в игру AI не удивляет. Они используют несколько иной подход, хотя адаптируют существующую технологию, которая использует преимущества Qualcomm. Они разработали Neural Processing Engine, который является SDK, который позволяет разработчикам оптимизировать приложения для запуска различных приложений AI на процессорах Snapdragon 600 и 800. В конечном итоге эта интеграция означает большую эффективность.

Изображение предоставлено Qualcomm

Facebook уже начал использовать свой SDK для ускорения фильтров дополненной реальности в мобильном приложении. На веб-сайте Qualcomm говорится, что он также может использоваться, чтобы помочь распознавать объекты устройства и обнаруживать объект для лучшей композиции выстрела, а также сделать возможным украшение после обработки. Они также обещают больше возможностей через виртуального помощника голоса и гарантируют пользователям широкие рыночные приложения - «от здравоохранения до безопасности, от множества мобильных и встроенных устройств», - пишут они. Они также обладают превосходной защитой от вредоносных программ.

«Это позволяет вам выбирать свое ядро выбора по сравнению с профилем мощности, который вы хотите для своего пользователя», - сказал Гэри Бротман, глава Qualcomm по AI и машинного обучения.

SDK Qualcomm работает с популярными структурами AI, включая Tensor Flow, Caffe и Caffe2.

Google Cloud TPU

Чип AI от Google появился относительно рано в игре AI, нарушив то, что было довольно необычным рынком. И Google не планирует продавать процессор, вместо этого распределяя его с помощью нового облачного сервиса, из которого каждый может создавать и управлять программным обеспечением через Интернет, в котором используются сотни процессоров, упакованных в центры обработки данных Google, сообщает Wired.

Чип, называемый TPU 2.0 или Cloud TPU, является продолжением первоначального процессора, который принес услуги AI от Google, но его можно использовать для обучения нейронных сетей, а не для запуска их, как своего предшественника. Разработчикам необходимо изучить другой способ построения нейронных сетей, поскольку он предназначен для Tensorflow, но они ожидают - учитывая, что доступность чипа - это то, что пользователи будут соблюдать. Google упомянул, что исследователи, которые делятся своими исследованиями с большей публикой, получат бесплатный доступ.

Изображение предоставлено Google

Джефф Дин, который возглавляет лабораторию искусственного интеллекта Google Brain, говорит, что чип должен был тренироваться с большей эффективностью. Он может обрабатывать 180 триллионов операций с плавающей запятой в секунду. Несколько микросхем соединяются, чтобы сформировать блок, который предлагает 11 500 терафлоп вычислительной мощности, а это означает, что для обучения 32 плат ЦП на части стручка требуется всего шесть часов, это заняло целый день.

Intel Movidius Neural Compute Stick

Intel предлагает чип AI с помощью Movidius Neural Compute Stick, который является устройством USB 3.0 со специализированным процессором обработки изображений. Он должен дополнить Xeon и Xeon Phi и стоит всего 79 долларов.

Хотя он оптимизирован для приложений видения, Intel заявляет, что может обрабатывать различные приложения DNN. Они пишут: «Разработанный разработчиками, исследователями и производителями продуктов, Movidius Neural Compute Stick стремится уменьшить препятствия для разработки, настройки и развертывания приложений ИИ путем предоставления специализированной высокоэффективной обработки глубоких нейронных сетей в небольшом форм-факторе».

Изображение предоставлено Movidius

Палка питается от VPU, как то, что вы можете найти в смарт-камерах безопасности, беспилотных летательных аппаратах и промышленном оборудовании. Он может использоваться с обученной Curee-каркасной конвейерной нейронной сетью с прямой связью или пользователь может выбрать другую предварительно подготовленную сеть, сообщает Intel. Movylius Neural Compute Stick поддерживает Cnn-профилирование, прототипирование и настройку рабочего процесса, обеспечивает питание и данные через один порт USB типа A, не требует облачной связи и запускает несколько устройств на одной платформе.

С малины Pi на ПК Movivius Neural Compute Stick можно использовать с любой платформой USB 3.0.

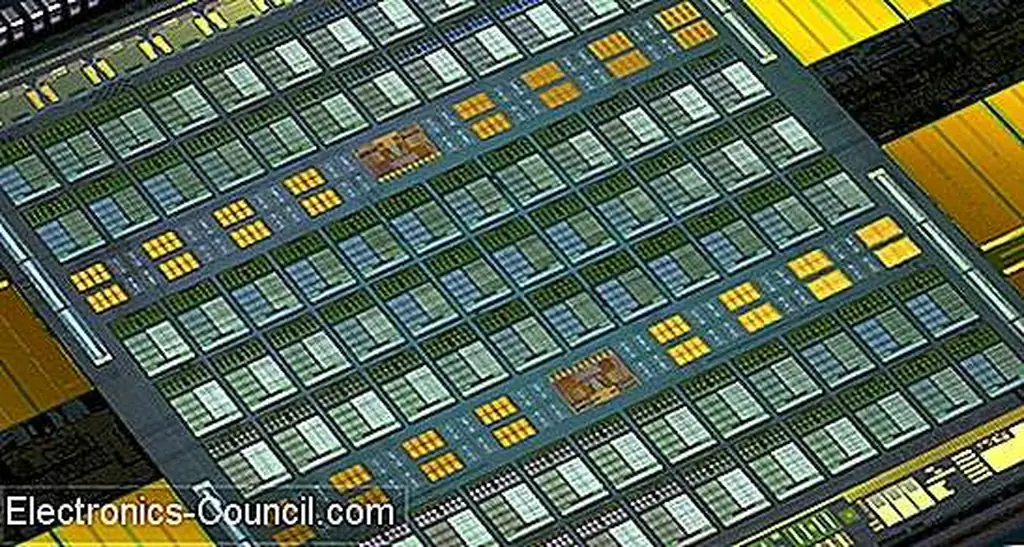

NVIDIA Tesla V100

NVIDIA первой стала серьезно относиться к ИИ, но теперь они еще более серьезны. Их новый чип - Tesla V100 - это GPU для центров обработки данных. Как сообщается, это вызвало большой резонанс в связи с тем, что акции NVIDIA выросли на 17, 8% на следующий день после анонса.

Изображение предоставлено NVIDIA

Чип выделяется в процессе обучения, что обычно требует умножения матриц данных на одно число за раз. Вместо этого архитектура Volta GPU сразу умножает ряды и столбцы, что ускоряет процесс обучения AI.

С 640 тензоревыми сердечниками Volta в пять раз быстрее, чем Pascal, и сокращает время обучения с 18 часов до 7, 4 и использует технологию высокоскоростного соединения следующего поколения, которая, согласно веб-сайту, «позволяет использовать более продвинутые модели и данные для параллельных подходов для сильного масштабирования для достижения абсолютной максимальной производительности приложений ».

Слышали о том, что больше чипов AI спускается по трубе? Дайте нам знать в комментариях ниже!