Краткий обзор рекомендаций и ограничений карты сайта в Google и Bing, а также некоторые советы по оптимизации карты сайта. Также изучите технику, которая поможет вам выявить проблемы со сканированием и индексацией с помощью нескольких карт сайта в Инструментах Google для веб-мастеров.

Несмотря на то, что карты сайта представляют собой просто списки канонических URL-адресов, отправленных в поисковые системы, удивительно, насколько редко можно встретить идеальный вариант. Проблемы часто возникают, когда владельцы крупных сайтов используют инструменты автоматического создания карты сайта, которые не настроены должным образом. Эти сайты обычно сталкиваются с проблемами для сканеров поисковых систем, такими как разбивка на страницы и URL-адреса, генерируемые фасетной навигацией.

Пауки решают, какие страницы сканировать, на основе URL-адресов, помещенных в очередь из предыдущих сканирований, и этот список дополняется URL-адресами из XML-карт сайта. Таким образом, карты сайта могут быть ключевым фактором в обеспечении доступа поисковых роботов и оценке контента, наиболее подходящего для показа в результатах поисковых систем.

Ниже приводится краткий обзор рекомендаций и ограничений карты сайта поисковых систем, а также метод, помогающий выявить проблемы сканирования и индексации с использованием нескольких карт сайта в Инструментах Google для веб-мастеров.

Обзор рекомендаций и ограничений Bing и Google

Протокол карты сайта стал стандартом, принятым поисковыми системами в 2006 году. С тех пор Bing и Google разработали полезные информационные панели инструментов для веб-мастеров, которые помогают владельцам сайтов выявлять и исправлять ошибки.

Из двух поисковых систем Bing особенно имеет низкий порог, или, по крайней мере, они внешне заявляют, что начинают обесценивать карты сайта, если 1 процент URL-адресов приводит к ошибке (возвращает что-либо, кроме кода состояния 200).

Google предоставляет четкие рекомендации, ограничения и более надежную систему отчетов об ошибках при использовании панели управления для веб-мастеров. Помимо отправки качественных файлов Sitemap, убедитесь, что файлы не выходят за рамки следующих жестких ограничений, применимых к Google.

- Ограничить количество URL-адресов в файлах Sitemap до 50 000

- Размер файла не должен превышать 50 МБ

- 500 карт сайта на аккаунт

Обе поисковые системы поддерживают индексные файлы карты сайта. Вместо отправки нескольких файлов карты сайта по отдельности индексный файл карты сайта упрощает отправку нескольких файлов карты сайта любого типа одновременно.

Базовая оптимизация карты сайта

Базовая оптимизация карты сайта должна включать проверку страниц, которые:

- Дублируется (несколько URL-адресов в разных файлах Sitemap допустимы)

- Возврат ошибок кода состояния - 3XX, 4XX и 5XX

И любые страницы, на которых указано:

- Мета-канонические тексты, не являющиеся самореферентными

- Метатеги роботов Noindex

Существуют инструменты для быстрого анализа URL-адресов, содержащихся в XML-файлах, и поиска этой информации, например SEO-сканер Screaming Frog.

Использование инструментов Google для веб-мастеров

После того как подробные и качественные XML-карты сайта будут отправлены в Google и Bing, разбивка карт сайта на категории может дать более глубокое понимание проблем сканирования и индексации.

Отличное начало - разбить файлы Sitemap по типам страниц. Карты сайта можно разбивать на кусочки любым удобным для вас способом, чтобы обеспечить обратную связь. Основная цель - выявить любые области сайта с низким уровнем индексации.

Как только область определена, можно приступить к поиску источника проблемы. Использование робота Fetch as Googlebot для выявления несканируемого контента и ссылок часто оказывается очень полезным.

Другой особенно полезный метод - использовать множественную идентификацию индексации карты сайта (или MSII, аббревиатуру, которую я только что придумал) в сочетании с операторами расширенного поиска в попытке найти избыточную индексацию.

Так, например, гипотетически, если на вашем веб-сайте возникают проблемы с индексацией сообщений, было бы полезно создать XML-карту сайта, содержащую только сообщения в блоге. Исходя из этого, можно рассчитать уровень индексации и использовать расширенный поиск, чтобы увидеть, какие другие страницы могут ухудшать сканирование и индексацию страниц сообщений.

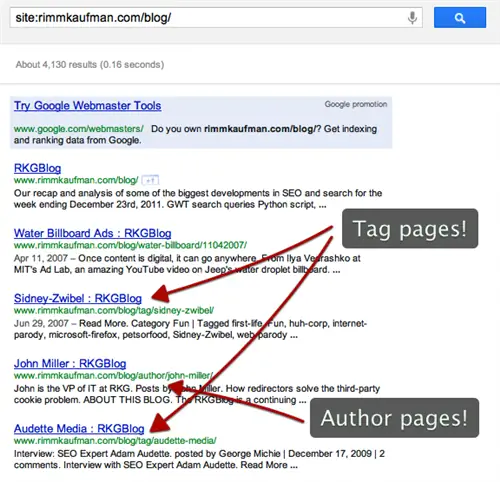

Поиск ниже показывает, что страницы тегов и авторов могут быть гипотетической помехой.

Дополнительные расширенные поисковые запросы Google, такие как site:example.com/blog/ inurl:tag И inurl:author, можно затем выполнить, чтобы определить масштаб потенциального избыточного сканирования и индексации. Та же концепция может быть применена к динамическим параметрам, содержащимся в URL-адресах, созданных с помощью фасетной навигации, нумерации страниц, сортировки продуктов и т. д.